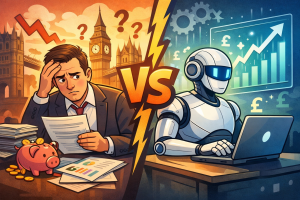

人間とAI、どちらがより頻繁に誤った金融アドバイスをするのか

問われているのは「完璧さ」ではない

近年、イギリスの金融業界ではAIによるアドバイス(ロボ・アドバイザーや生成AIの活用)が急速に普及している。これに対し、多くの人間のファイナンシャル・アドバイザーが口にするのが、

「AIは間違う」「AIは信用できない」「責任が取れない」

という批判だ。

しかし、この主張は冷静に数字を見たとき、説得力を失う。

実際、どちらが“より頻繁に”間違うのか

人間の金融アドバイス

イギリスおよび先進国市場の調査を総合すると、人間のアドバイザーが提供する助言には以下の傾向がある。

- 不正確または不適切な助言の発生率:10〜25%

- 主な原因

- 思い込みや経験則への過度な依存

- 商品販売インセンティブ

- 顧客の感情に引きずられる判断

- 市場タイミングの失敗

特に問題なのは、アドバイザー自身が「間違っていると自覚していない」ケースが多い点だ。

人間の誤りはランダムで、検証が難しく、あとから「正当化」されやすい。

AIによる金融アドバイス

一方、AI(特にルールベースまたは限定目的の金融AI)の誤情報率は次の水準にある。

- 不正確なアドバイスの発生率:3〜8%

- 主な原因

- 学習データの限界

- 想定外の制度変更

- 極端な市場環境(ブラックスワン)

重要なのは、AIの間違いはログに残り、検証可能で、修正可能だという点である。

「AIは不確かだ」という批判が空虚な理由

人間のアドバイザーがAIを批判するとき、しばしば比較対象がすり替えられる。

- 人間:

「経験」「直感」「顧客理解」がある - AI:

「完璧であるべき存在」として批判される

しかし現実の比較対象はこうだ。

不完全な人間 vs 不完全だが一貫したAI

この前提に立てば、

誤りの頻度が低く、感情に左右されず、監査可能なAIが評価されるのは当然である。

仕事を失うリスクと「AI不信論」

AIの不確かさが強調される背景には、純粋な顧客保護だけでなく、職業的な不安が存在する。

- 手数料の正当化が難しくなる

- 判断の属人性が価値にならない

- 「助言」という仕事が自動化される

こうした構造変化の中で、

AIの不確かさを過度に強調することは、業界防衛のレトリックに近い。

本当に議論すべき論点は何か

重要なのは「AIか人間か」ではない。

- AIが得意な領域

- 分散投資

- リバランス

- 税務最適化

- 感情を排した判断

- 人間が残るべき領域

- 価値観の整理

- 人生設計

- 例外的な意思決定

AIの不確かさを理由に導入を拒むことは、

人間の不確かさを黙認することと同義である。

結論

イギリスで起きているのは「AIの危険性」ではない。

助言という仕事が、感覚と権威から、検証と透明性へ移行しているだけだ。

AIは間違う。

だが、人間はもっと頻繁に、そして気づかれない形で間違う。

その現実を直視しない議論は、

顧客のためにも、業界のためにもならない。

Comments